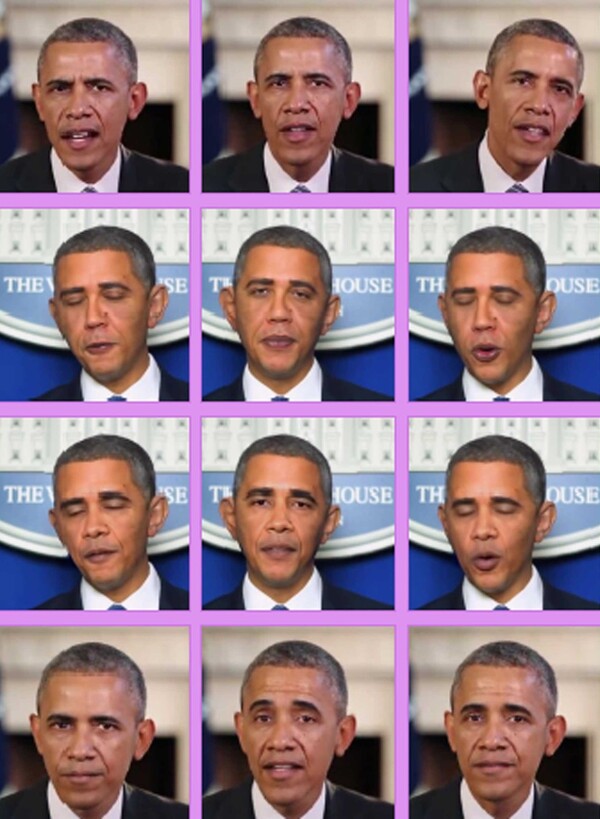

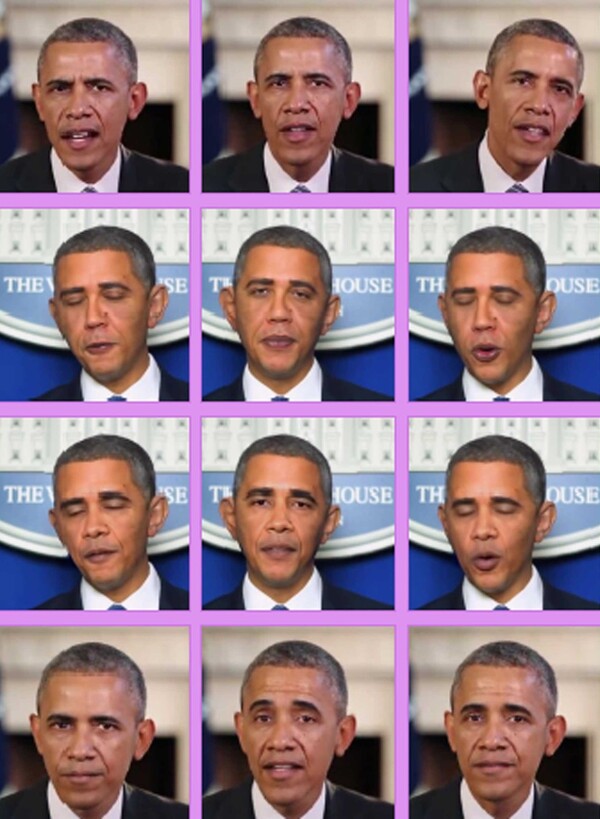

가짜 영상·음성 악용 방지 캠페인 전개

AI 사용자·소비자 대상 서명운동 시작

악용 위험성 전파·방지 기술개발 지원도

“불신의 사회 조장…선거로 기승 부릴 듯”

AI 사용자·소비자 대상 서명운동 시작

악용 위험성 전파·방지 기술개발 지원도

“불신의 사회 조장…선거로 기승 부릴 듯”

한국인공지능윤리협회 제공

항상 시민과 함께하겠습니다. 한겨레 구독신청 하기

등록 2020-01-06 18:02수정 2020-01-06 18:20